L’Europa non vuole farsi trovare impreparata si sta preparando a regolamentare il mondo delle intelligenze artificiali con l’AI Act, una nuova normativa che punta a tutelare gli umani da questo fenomeno. Nell’arco di pochi mesi, l’argomento è passato da essere qualcosa di astratto per molti a un fenomeno che sta prendendo il sopravvento; lo stiamo vedendo soprattutto con Microsoft, con Bing che adesso è anche in grado di creare immagini e un Office totalmente rivoluzionato, per non parlare di ChatGPT o gli incredibili risultati di Midjourney, per citare gli esempi più conclamati.

L’Europa prepara l’AI Act per regolamentare il mondo delle intelligenze artificiali

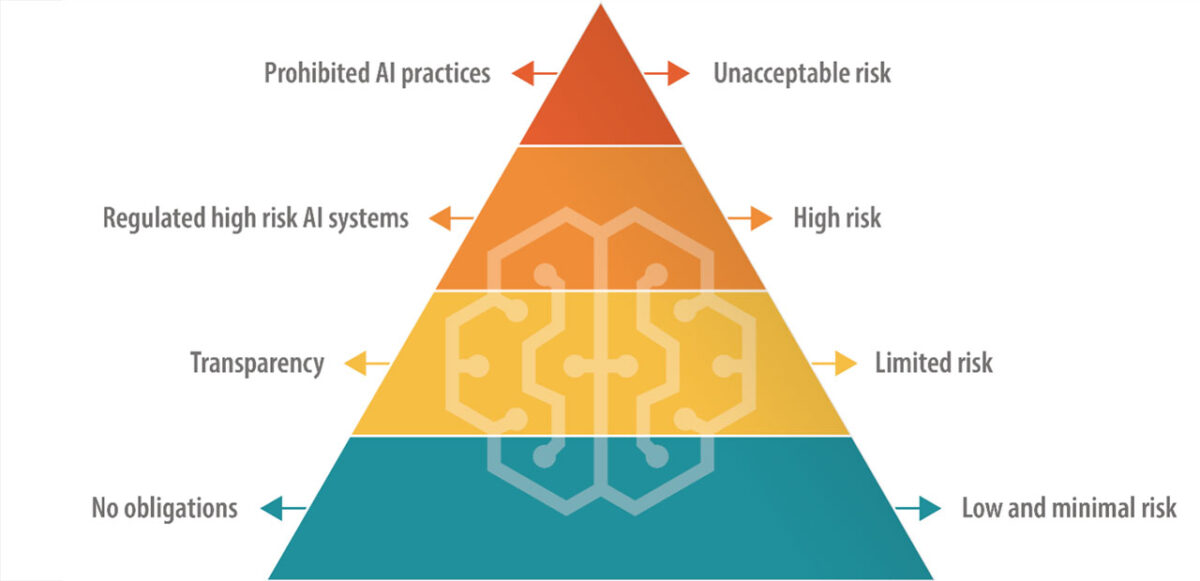

Di fronte a una rivoluzione tecnologica del genere, è più che lecito che sorgano preoccupazioni sugli effetti che potrebbe avere sulla società. Per questo, l’AI Act classificherà le IA sulla base del livello di rischio percepito, partendo da “basso” fino a “inaccettabile” (e quindi da bloccare). Ciò comporterà obblighi per chiunque fornisca prodotti e servizi che utilizzano intelligenza artificiale, in particolare quei sistemi che forniscono contenuti, previsioni e consigli con potere decisionale. I legislatori stanno anche valutando quale livello associare ai General Purpose AI System (GPAIS), cioè utilizzabili per più scopi come nel caso delle IA generative, e l’eventualità di affiancargli strumenti che facciano capire all’utente se quel contenuto è stato creato da un umano o meno.

La normativa sarà in sinergia con la legge GDPR sulla tutela dei dati, e ci saranno forti obblighi di trasparenza per i sistemi IA che interagiscono con umani, che vengono usati per sorveglianza e per creare deepfake. Le intelligenze artificiali ad alto rischio saranno quelle coinvolte in settori come forze dell’ordine, istruzione, trasporti, gestione lavorativa, infrastrutture sensibili, flussi migratori, giustizia, sicurezza e servizi pubblici/privati essenziali, e dovranno registrare tutte le attività e metterle a disposizione delle autorità. C’è poi l’annoso problema delle “scatole nere”: spesso, infatti, i sistemi IA non rendono chiaro il processo di elaborazione dei dati, con tutte le problematiche annesse, come può essere la possibile violazione di copyright nella generazione artificiale di contenuti multimediali; fortunatamente, in alcuni casi le compagnie stesse rendono pubblici i cosiddetti strumenti Explanaible AI, permettendo agli utenti di capire come un’IA abbia agito per produrre quel contenuto. Trovare il giusto equilibrio fra trasparenza e tutela delle tecnologie non è facile, anche perché moltissime di queste IA non operano in Europa.

In caso di violazione dell’AI Act, si prevedono multe fino a 30 milioni di euro o il 6% dei profitti globali; nel caso di Microsoft, per esempio, una multa del genere significherebbe vedersi tagliata via oltre 10 miliardi. Attualmente, l’AI Act è in fase di discussione, dopodiché ci sarà un confronto fra Commissione europea, Parlamento europeo e Consiglio dell’Unione Europea; in lavorazione da oltre 2 anni, non c’è ancora una data per il suo debutto, anche se si prevede che potrebbe avvenire nel corso del 2023, seppure sia previsto un periodo di 2 anni per permettere alle parti coinvolte di adeguarsi.

⭐️ Scopri le migliori offerte online grazie al nostro canale Telegram esclusivo.