Ebbene sì, anche tecnologie che nascono per essere quanto più automatizzate possibile come l’intelligenza artificiale necessitano dell’intervento umano per reggersi in piedi. Di ChatGPT si parla in lungo e largo, e se da un lato le discussioni vertono attorno alle sue enormi capacità, dall’altro evidenziano le falle di un sistema altamente energivoro, costosissimo e che a quanto pare si fonda sullo sfruttamento dei paesi emergenti e delle condizioni lavorative delle loro popolazioni.

Un’inchiesta svela i problemi strutturali di una tecnologia come GPT e dell’impatto psicologico sui suoi lavoratori

La sigla “GPT” si traduce in “Trasformatore Generativo Pre-addestrato”, e il pre-addestramento di GPT-3 fu composto da due fasi: la prima in cui gli vennero dati in pasto 750 GB di dati testuali presi dalla rete e la seconda, in cui persone in carne e ossa filtrarono via contenuti controversi e illegali che inevitabilmente rientrano in quei gigabyte di dati. È grazie al pre-addestramento se GPT e servizi annessi, compresi ChatGPT e Bing, restituiscono risposte pulite, cercando di non soddisfano le richieste di chi vorrebbe tirare la corda; è comunque un sistema imperfetto, e lo dimostrano gli screenshot che girano in rete di chatbot in preda alle allucinazioni e in grado di generare contenuti pericolosi, illegali e di finire vittime di censura.

L’inchiesta del Time ha quindi analizzato documenti, buste paga e intervistato lavoratori in merito all’operato di Sama, azienda di outsourcing di San Francisco focalizzata sull’allenamento dei sistemi di intelligenza artificiale per realtà quali Google, Meta e Microsoft, assoldata da OpenAI per compiere la seconda fase del pre-addestramento. Con “outsourcing” si indica l’affidamento degli incarichi a lavoratori esterni, solitamente in paesi emergenti come in questo caso l’Africa, ma anche India, Sud-est asiatico e Sud America; Sama si fregia di essere un’azienda “per un’IA etica” e di aver fatto uscire dalla povertà oltre 50.000 persone in difficoltà.

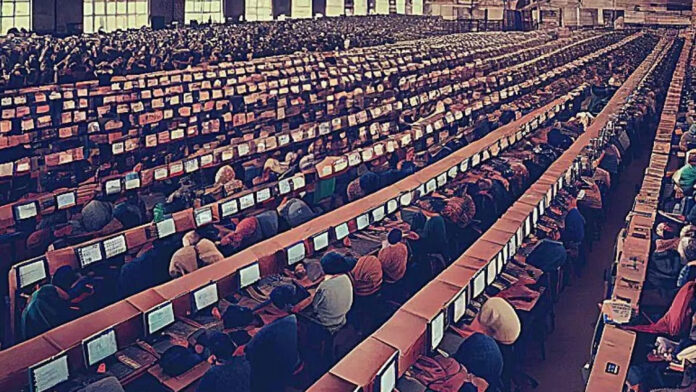

L’obiettivo di OpenAI era quello di alimentare l’IA con esempi di contenuti controversi e illegali per farle imparare a riconoscerli ed eliminarli prima che arrivino all’utente finale. Ne nacquero tre contratti con Sama da 200.000$ per l’etichettature di contenuti riguardanti abusi sessuali, incitamento all’odio e violenza, con la creazione di team da 12 persone per ognuna di queste categorie, incaricati di leggere ed etichettare 150/200 parti testuali da 100/1.000 parole in turni da 9 ore. OpenAI ha confermato la collaborazione con Sama per la costruzione del sistema per la rilevazione e la rimozione di contenuti tossici, un obiettivo virtuoso ma sulla pelle di lavoratori che hanno barattato la propria stabilità psicologica per un lavoro altamente rischioso.

A fronte di una paga oraria di 12,50€, Sama pagava i lavoratori attorno agli 1/2$ l’ora, e tutti gli intervistati del Time si sono dichiarati “mentalmente segnati” dall’esperienza; un lavoratore ha dichiarato di aver avuto forti ripercussioni sulla psiche dopo essersi imbattuto in contenuti come la descrizione di un rapporto sessuale con un animale in presenza di un bambino: “Era una tortura, leggevo tutta la settimana cose del genere e quando arrivava il weekend non riuscivo a non pensarci, continuando a esserne disturbato“. Nonostante ci fossero psicologi a supporto dei lavoratori, gli intervistati lamentano il fatto di aver potuto partecipare solamente a sessioni di gruppo, meno efficaci di quelle individuali.

Inoltre, Sama iniziò a lavorare per OpenAI anche alla creazione di un sistema IA anche per le immagini, etichettando immagini sessuali, violente e in alcuni casi persino illegali, passaggio ritenuto “necessario” da OpenAI per la salvaguardia di sistemi come DALL-E; si parla di un archivio di 1.400 immagini siglate come C4 (abusi sessuali su minori), C3 (bestialità, stupro, schiavitù sessuale) e V3 (morte, violenza e gravi lesioni fisiche), per un compenso totale a Sama di circa 787$. Sono state talmente tante le segnalazioni di traumi emotivi che Sama ha deciso di cancellare il suo rapporto lavorativo con OpenAI otto mesi prima del previsto e annullare tutte le prossime collaborazioni; cercando sul sito ufficiale non si trovano menzioni all’azienda di Sam Altman. Tuttavia, OpenAI ha affermato di aver lavorato con Sama per “creare sistemi di intelligenza artificiale più sicuri e prevenire risposte dannose” ma di non aver mai richiesto l’analisi di contenuti C4 e che Sama abbia frainteso le richieste. L’azienda è stata coinvolta anche nell’outsourcing in Africa dei team di moderazione di contenuti per Facebook, sottoponendo i lavoratori a immagini e video di abusi minorili, stupri ed esecuzioni per 1,50€ all’ora, decidendo infine di non rinnovare il contratto da quasi 4 milioni con Meta

⭐️ Scopri le migliori offerte online grazie al nostro canale Telegram esclusivo.