L’essere umano ha sempre sentito la necessità di preservare per i posteri il ricordo del presente e, di conseguenza, di rendere immortali i momenti importanti attraverso descrizioni scritte o rappresentazioni grafiche. In effetti la presenza di un comparto fotografico nei nostri smartphone risponde proprio a questo bisogno che, fortunatamente, oggi può essere soddisfatto in ogni momento con il semplice tocco di un dito.

Domenica scorsa vi abbiamo parlato proprio delle tecnologie che permettono ai nostri dispositivi di scattare foto di ottima qualità senza incidere troppo sui costi di produzione (il prezzo di un modulo fotografico completo oscilla di solito tra i 5 ed i 15 Dollari) e sulle dimensioni del terminale. Oggi, invece, ci concentreremo come da tradizione sulle possibili innovazioni che in futuro potrebbero migliorare la qualità delle foto o stravolgere il nostro modo di concepire la fotografia in ambito mobile.

Parleremo quindi della tendenza ad integrare in hardware molte delle funzioni finora gestite via software (quindi della stabilizzazione ottica dell’immagine ed i nuovi sistemi di messa a fuoco automatica), del crescente utilizzo di filtri e tecniche digitali per il miglioramento delle immagini e, infine, delle più importanti novità hardware che segneranno l’evoluzione dei moduli fotografici attuali.

La cattura di un fotogramma da parte del sensore fotografico è un processo dinamico e, in quanto tale, ha bisogno di tempo per essere completata. Durante questo tempo difficilmente l’immagine proiettata dal sistema ottico sul sensore resterà immutata, ed anzi è possibile che alla fine del processo il SoC riceva dei dati che, essendo dovuti alla media della luce che ha colpito ogni singolo photosite, siano ben distanti dal rappresentare la scena che intendevamo fotografare (immagine mossa).

Per evitare questo inconveniente la strada comunemente più seguita è quella di ridurre i tempi di esposizione aumentando la sensibilità del sensore e, di conseguenza, il rumore. Quando si utilizza la fotocamera per riprendere un video può poi entrare in gioco la stabilizzazione elettronica che, seguendo gli spostamenti dell’immagine sul sensore, restituisce un video dal campo angolare ridotto ma quasi privo di vibrazioni e tremolii.

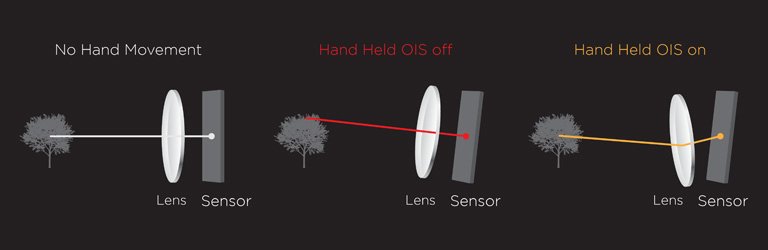

Per fortuna esistono da tempo anche sistemi più raffinati e potenti per evitare gli effetti delle microvibrazioni che, in maniera analoga all’occhio di una persona che legge su un mezzo di trasporto, compensano meccanicamente il movimento della fotocamera rispetto alla scena. Si tratta dei sistemi di stabilizzazione ottica (OIS) in cui, istante per istante, un giroscopio controlla tramite elettromagneti il movimento di una lente o del sensore per compensare i tremolii della mano.

Questo sistema, sia chiaro, è del tutto inutile in assenza di vibrazioni (con un treppiede, ad esempio) e non ha alcun effetto nel ridurre il motion blur di oggetti in movimento (dovuto alla dinamicità della scena e non al moto della fotocamera). In questo ultimo caso, quindi, la stabilizzazione ottica deve essere affiancata da bassi tempi di esposizione per le foto e da un elevato numero di fotogrammi al secondo (che possono essere anche utilizzati per lo slow motion) per i video.

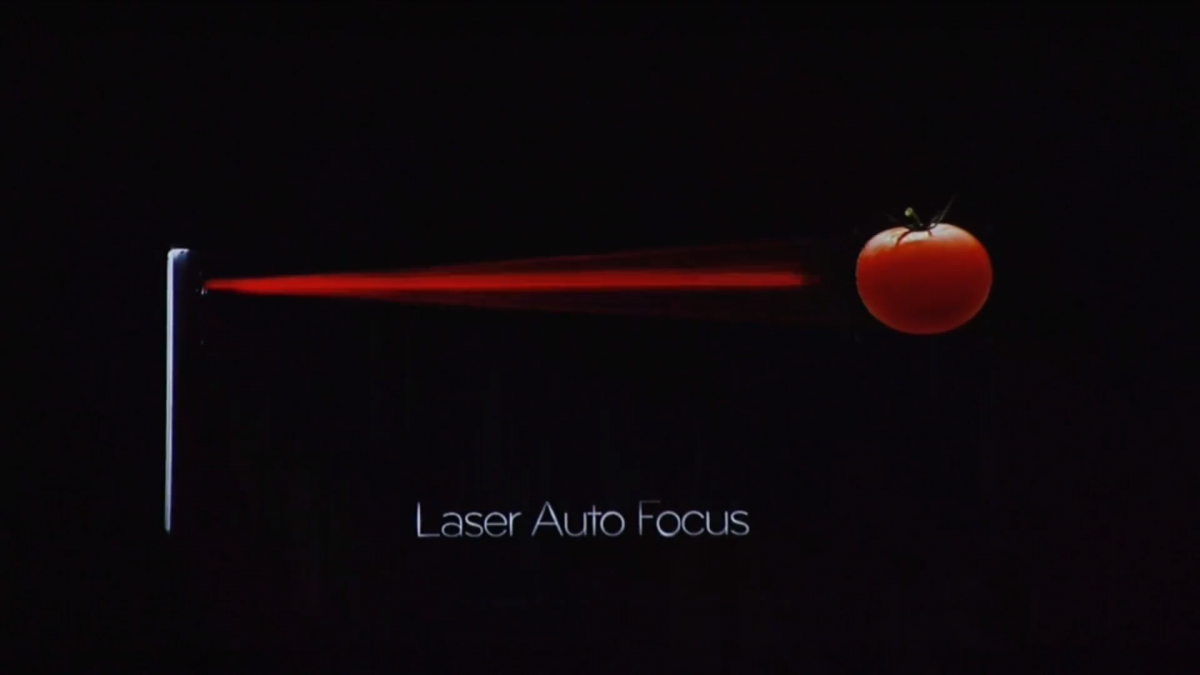

Dobbiamo ammettere che l’adozione di hardware dedicato è spesso conveniente, dal punto di vista qualitativo, rispetto all’uso di algoritmi software che ne emulino la funzione. Questa stessa constatazione ha spinto negli ultimi tempi molti produttori ad adottare sistemi di autofocus attivo, che utilizzano l’emissione di un segnale per rilevare la distanza dell’oggetto di cui si vuole catturare l’immagine.

La misura della distanza da parte di questi sistemi, in particolare, avviene in due fasi. In un primo momento, infatti, una sorgente (di solito di ultrasuoni o luce infrarossa) emette un segnale facilmente distinguibile dal background. La risposta dell’ambiente a questo segnale, poi, sarà registrata da un sensore dedicato e comunicata all’ISP. Confrontando tale risposta con quella attesa nel caso in cui la scena da riprendere sia molto distante, dunque, l’ISP può triangolare la posizione dell’oggetto da mettere a fuoco e muovere le lenti di conseguenza.

I sistemi attivi, grazie all’utilizzo del sensore esterno dedicato, sono spesso più veloci dei sistemi passivi (che poggiano le loro basi sull’analisi dell’immagine fotografica). Se uno smartphone dotato di fotocamera con autofocus a contrasto impiegherà circa un secondo per catturare una scena, ad esempio, uno dotato di sistema a laser infrarossi impiegherà meno di un quarto di quel tempo. Gli autofocus attivi, d’altra parte, saranno spesso meno precisi e si lasceranno facilmente ingannare da superfici semitrasparenti di vetro e plastica.

Alcuni sistemi passivi, poi, possono contare su una rapidità di scatto eccezionale mantenendo una qualità elevata. Il PDAF (di cui vi abbiamo già parlato la scorsa volta), ad esempio, può impiegare meno di un terzo di secondo per completare il suo lavoro e rappresenta un ottimo compromesso tra i due mondi.

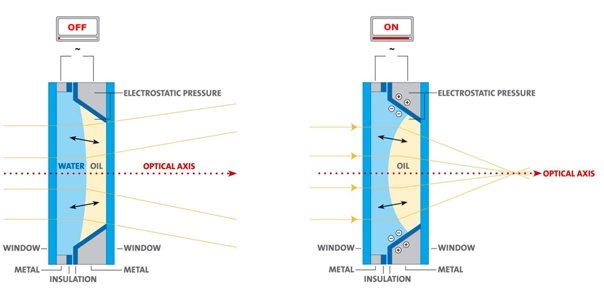

In futuro, infine, potrebbero diffondersi moduli fotografici dotati di liquid lens (in cui due liquidi immiscibili sono controllati tramite campi elettrici) che, grazie all’incredibile flessibilità di questo componente, potrebbero avvicinare ulteriormente i sistemi passivi alle velocità di quelli attivi.

La tendenza di aumentare il numero di Megapixel non si è mai assopita e, lentamente ma inesorabilmente, il mercato si sta popolando di moduli dalla risoluzione sempre più elevata. È giusto chiedersi, tuttavia, quanto questa corsa sia davvero positiva per i consumatori e quanto, piuttosto, sia dovuta a semplici motivi di marketing.

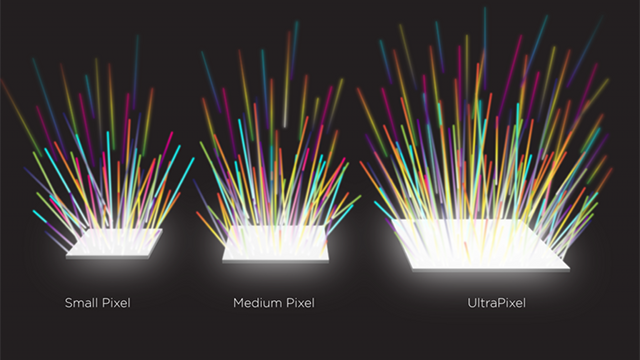

Se si aumenta il numero di pixel integrati sul sensore senza aumentare anche la dimensione dell’area sensibile, infatti, si otterranno photosite sempre più piccoli che raccoglieranno meno luce. Questo porta inesorabilmente ad un aumento del rumore e, in ultima analisi, a scarse prestazioni in condizioni di scarsa luminosità. Photosite troppo piccoli, poi, potrebbero portare ad un aumento del fenomeno del crosstalking, cioè l’interferenza tra vicini che non è affatto desiderabile.

La diffusione dei sensori BSI, da questo punto di vista, è motivata proprio dalla volontà di aumentare il numero di pixel senza diminuire l’intensità della luce che può arrivare al singolo photosite. Un buon isolamento ottico ed elettronico tra gli elementi fotosensibili (come quella garantita dalla tecnologia Isocell) può poi essere utile per ridurre il rumore e proseguire sulla via delle risoluzioni elevate .

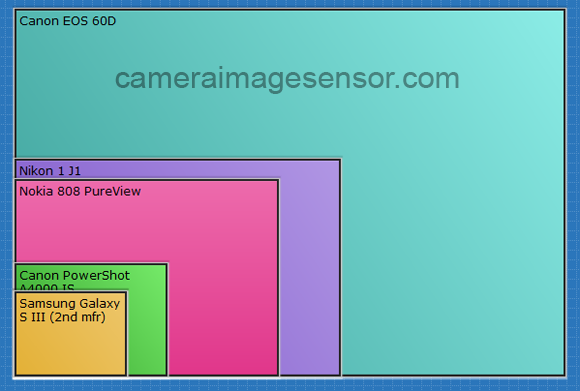

Non tutti i produttori sono d’accordo, comunque, sul sostenere che l’aumento dei Megapixel sia sempre desiderabile. Il nome Ultrapixel, ad esempio, nasconde la scelta tecnica di non partecipare alla corsa della risoluzione e di puntare, in maniera opposta, su pixel molto grandi e, di conseguenza, adatti ad ogni condizione di illuminazione. I sensori Pureview, invece, puntano su un’elevata dimensione del sensore e sull’oversampling dei pixel per catturare foto dall’ottima qualità.

Questi tre diversi approcci all’evoluzione dei sensori per smartphone presentano diversi vantaggi e svantaggi, e non è affatto detto che la crescita ad oltranza della risoluzione sia da evitare (sopratutto se affiancata da adeguati sviluppi tecnici). Un elevato numero di pixel è infatti vantaggioso in molte condizioni (è necessario ad esempio per l’uso di zoom digitali) e, se affiancato da un adeguato sistema ottico e ottenuto senza un corrispettivo aumento di rumore e aberrazioni, è probabilmente desiderabile. In futuro, comunque, ci auguriamo una stabilizzazione delle dimensioni dei photosite ed un corrispettivo aumento della superficie dei sensori.

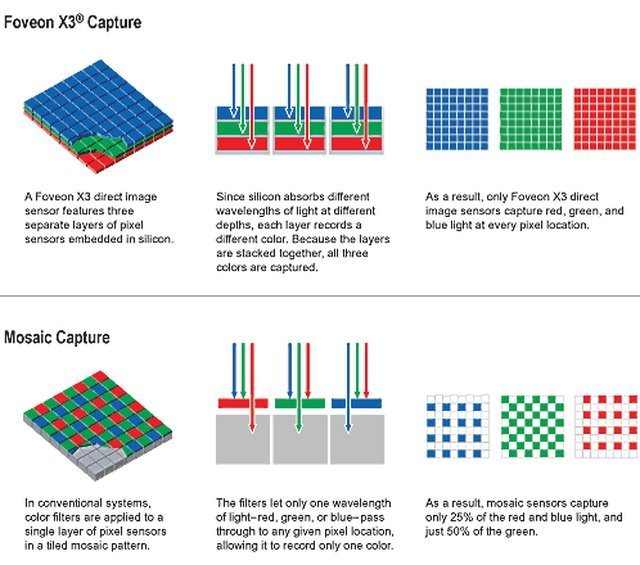

Domenica scorsa abbiamo visto come gli attuali sensori per fotocamere siano basati sullo schema Bayer e, di conseguenza, come ogni photosite raccolga le informazioni di solo uno dei colori principali. L’immagine completa è quindi calcolata tramite il demosaicing, che può tuttavia introdurre artefatti sui colori.

I sensori Foveon, in questo contesto, si offrono quale alternativa naturale a quelli basati su schema Bayer. Questa tecnologia, infatti, prevede che ogni photosite sia sensibile a tutti e tre i colori principali e che, di conseguenza, misuri nativamente tutte le componenti del pixel.

Questo risultato si basa sul fatto che la luce di frequenza più bassa (rossa) riesce a penetrare più in profondità lo strato di silicio che compone il photosite rispetto a quella di frequenza più alta (blu). È possibile, di conseguenza, sovrapporre tre sottilissimi sensori che, in base alla profondità a cui si trovano, registreranno componenti diverse della luce.

Questo tipo di sensore, comunque, non è (ad oggi) privo di difetti. La struttura stessa del photosite, ad esempio, favorisce la contaminazione tra i colori principali, cioè rende problematico l’aumento dell’accuratezza dei colori (comunque ottima). Nonostante l’ampia dimensione dei photosite, poi, questo sistema spesso si è dimostrato poco efficiente in condizioni di scarsa illuminazione, in quanto soffre particolarmente il rumore dovuto a sensibilità elevate.

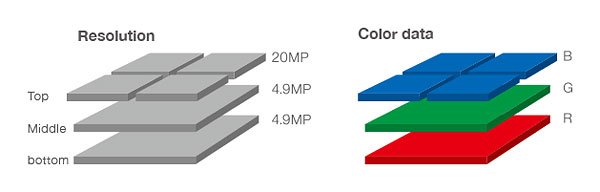

L’ultima evoluzione di questa tecnologia (Foveon Quattro), comunque, sembra aver risolto gran parte dei problemi grazie ad un approccio ibrido, in cui gli strati fotosensibili più profondi hanno risoluzione minore di quello più esterno. Sono già in fase di studio, infine, i sensori TFD (Transverse Field Detectors) che, moltiplicando il numero di starti sensibili, promettono colori dall’accuratezza eccezionale.

Se finora abbiamo parlato delle possibili evoluzioni hardware dei moduli fotografici, non dobbiamo dimenticare che anche l’evoluzione del software può portare ad ottimi miglioramenti qualitativi.

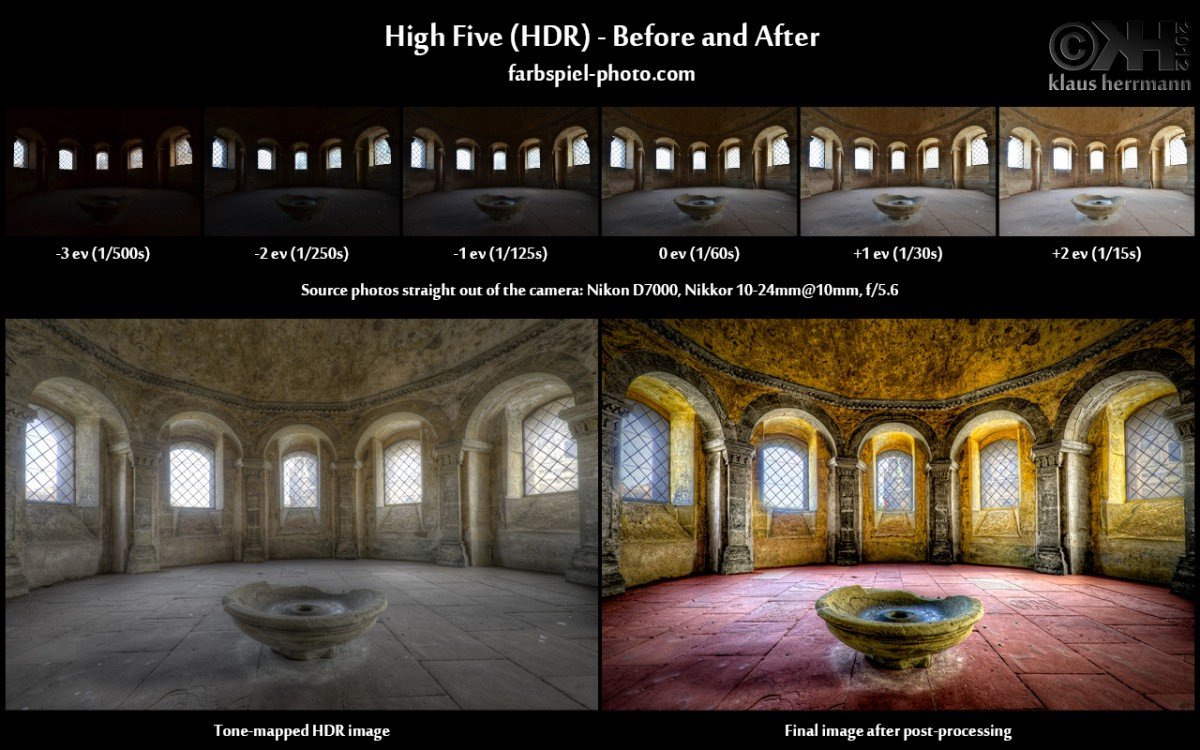

La diffusione della tecnologia HDR (High dynamic range), ad esempio, oggi ci consente di ottenere foto con ottimi intervalli dinamici, cioè capaci di riprodurre fedelmente i dettagli sia delle parti più scure che di quelle più illuminate. Questo risultato, che normalmente sarebbe quasi impossibile da raggiungere via hardware, è ottenuto calcolando l’immagine finale sulla base di diversi scatti effettuati con esposizioni diverse.

L’uso di algoritmi, quindi, non è sempre legato ai classici filtri che emulano effetti artistici (particolarmente apprezzati dal pubblico), ma può anche portare ad un effettivo aumento delle informazioni contenute nell’immagine. I casi recenti di smartphone con due fotocamere posteriori, ad esempio, devono le loro buone caratteristiche fotografiche solo ai tanti algoritmi che, sulla base delle due immagini scattate in contemporanea, consentono di scegliere via software gran parte delle proprietà della foto dopo il momento dello scatto (tra le quali il punto di fuoco).

La configurazione a doppia fotocamera, in realtà, è un caso semplificato di fotografia light-field, in cui l’ISP può ricavare le informazioni non solo riguardo l’intensità ed il colore della luce, ma anche sulla direzione in cui questa stava viaggiando. Questo permette ad un software apposito di emulare parametri di scatto che non sarebbero supportati nativamente dall’hardware oltre, naturalmente, la memorizzazione di foto 3D.

È giusto citare, infine, l’esistenza di alternative nel mondo della fotografia Light-field, come il sistema Lytro che si basa su un singolo sensore affiancato da una matrice di microlenti per raccogliere tutte le informazioni sui raggi luminosi. Questa tecnologia è attualmente costosa ed ingombrante, ma in futuro potrebbe facilmente arrivare anche sui nostri smartphone.

Dopo aver parlato di hardware e software non possiamo dimenticare di dedicare qualche parola all’usabilità dei moduli fotografici, che spesso è importante tanto quanto la qualità delle foto che questo componente riesce a regalarci. In questo contesto molte aziende si sono mosse per proporre design convincenti che consentano di catturare autoscatti con semplicità e comfort.

Tutte queste soluzioni si basano sull’idea di integrare una fotocamera che, potendo muoversi su una slitta o su una cerniera, si possa utilizzare come modulo sia anteriore che posteriore. I lettori più attenti ricorderanno sicuramente che queste soluzioni, un tempo molto diffuse nei vecchi cellulari a conchiglia, solo recentemente hanno trovato una propria espressione in ambito smartphone (sopratutto presso i produttori orientali).

L’evoluzione naturale di questi sistemi, comunque, consiste probabilmente nel proporre smartphone con moduli fotografici staccabili che, dotati di connessione bluetooth e batteria interna, possano essere attivati da remoto dal device madre. Un sistema del genere, per concludere, permetterebbe una grande flessibilità e potenzialmente potrebbe non essere troppo lontano dall’arrivare sul mercato.

Oggi abbiamo terminato la nostra gita nei grandi spazi della fotografia digitale. Il viaggio nel vasto mondo dei sensori dei nostri smartphone continua domenica prossima!